Los buenos directores de escuela pueden ser un factor determinante

“En general, se piensa que los buenos directores son la clave del éxito de las escuelas”. Es lo que sostienen Branch, Hanushek y Rivkin en su estudio sobre la incidencia de los directores de escuela en el aprendizaje de los alumnos. (PDF, en inglés) ¿Pero cómo puede medirse esta relación? Utilizando una base de datos de Texas (Estados Unidos), los autores aplicaron el enfoque del valor agregado (i) que normalmente se utiliza para medir el desempeño de los docentes. Controlaron las variables de información básica sobre los estudiantes (como el género, la etnia y un indicador de pobreza), así como los puntajes obtenidos en los exámenes del año anterior. A continuación se preguntaron: ¿qué sucede con el aprendizaje de los estudiantes cuando una escuela cambia de director? Así, concluyeron que cuando la calidad de los directores aumentaba 1 desviación estándar, el aprendizaje de los alumnos mejoraba 0,11 desviaciones estándar. Incluso después de algunos ajustes adicionales, sus estimaciones más conservadoras muestran que “el aumento de 1 desviación estándar en la calidad de los directores se traduce en alrededor de 0,05 desviaciones estándar en beneficios de aprendizaje promedio para los alumnos, lo que equivale aproximadamente a dos meses de aprendizaje adicional”.

Otro aspecto importante: mientras que la mejora de la eficacia de los docentes incide en el desempeño promedio de todos sus alumnos, la mejora de la eficacia de un director afecta el desempeño promedio de toda la escuela. Por lo tanto, los beneficios potenciales son elevados.

No todas las escuelas tienen buenos directores

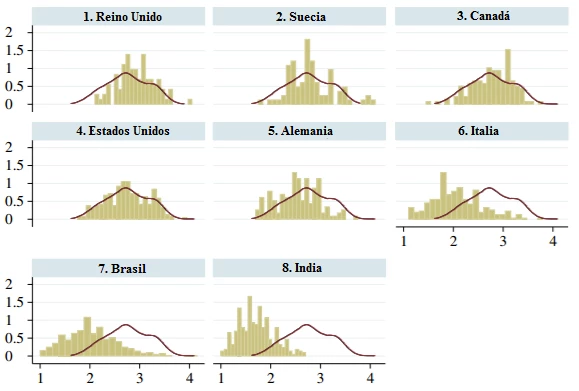

La calidad de la gestión de las escuelas varía considerablemente de un país a otro. Bloom y otros (PDF, en inglés) midieron la calidad de la gestión en 1800 escuelas secundarias en ocho países, utilizando una versión de la encuesta mundial de gestión adaptada a las escuelas. (PDF, en inglés) Como se muestra en el siguiente gráfico, la distribución de los puntajes de la gestión varía tanto dentro de los países como de un país a otro, y se observa un elevado número de escuelas mal administradas. Como sostuvo recientemente un académico sobre las escuelas de Estados Unidos, (i) “en general, los directores de escuela son administradores de nivel medio, y no verdaderos líderes institucionales”.

Fuente y notas: Bloom y otros, 2015. (PDF, en inglés) Las líneas rojas representan la distribución de la gestión de las escuelas de Estados Unidos (a los efectos comparativos). Las barras verticales muestran la distribución de los puntajes de la gestión en cada país. Los mejores puntajes referidos a la gestión se ubican a la derecha.

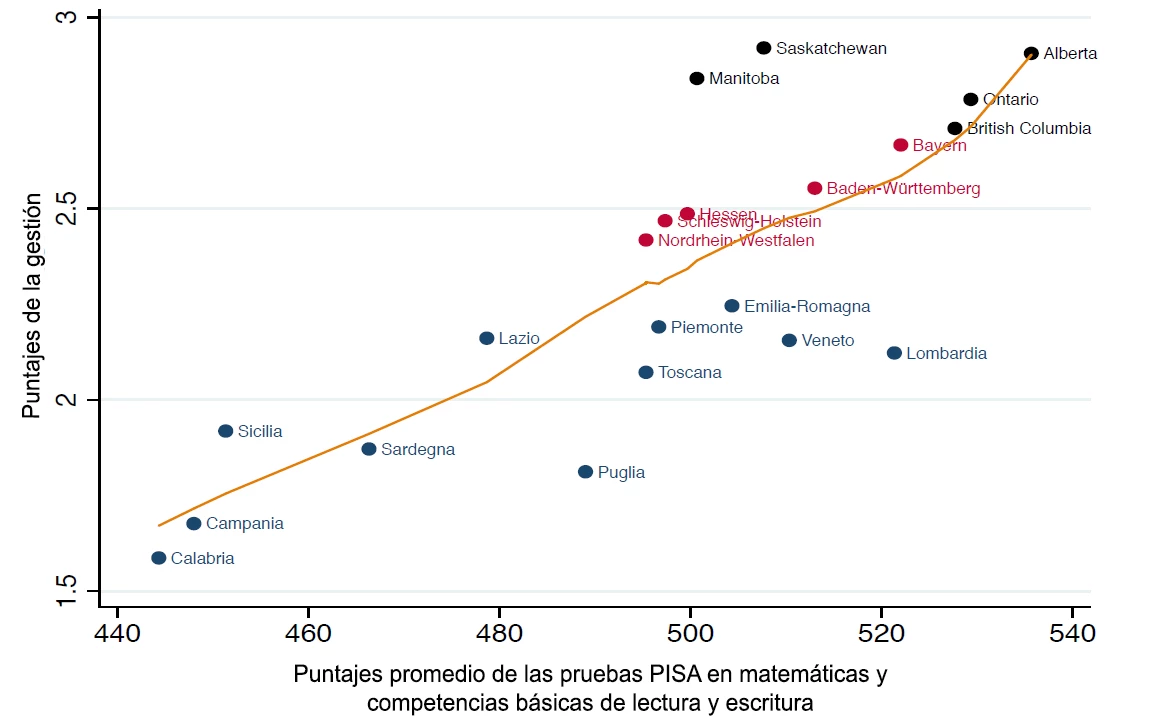

Cuando dichos puntajes se relacionan con el desempeño de los alumnos, la correlación resulta evidente.

Fuente y notas: Fryer, 2017. (i) Los datos regionales provienen de Alemania, Canadá e Italia.

¿Los directores de escuela pueden mejorar?

Si bien en una gran cantidad de obras se examinan las intervenciones orientadas a la “gestión de las escuelas”, la mayoría se centra en la necesidad de promover la participación de la comunidad en las decisiones de las escuelas y no tanto en mejorar la calidad del liderazgo o la gestión del director. Por ello, el nuevo documento de trabajo de Roland Fryer sobre el impacto que genera la capacitación de los directores (i) resulta de especial interés. En sus propias palabras: “Hasta el momento, todas las evidencias sobre la relación entre la gestión de las escuelas y los logros de los alumnos han estado correlacionadas”.

Volvamos a Texas. Los directores de la mitad de las 58 escuelas analizadas recibieron capacitación intensiva en gestión. (Las escuelas fueron seleccionadas de manera aleatoria utilizando pares coincidentes, con una distribución relativamente uniforme entre la primaria y los ciclos inferior y superior de la secundaria. Los pares se establecieron tomando como base los niveles y los puntajes obtenidos en las pruebas anteriores a la intervención). Se impartieron 300 horas de capacitación a lo largo de dos años. Esto incluyó una semana de formación cada verano, orientación permanente de un instructor, un conjunto de evaluaciones provisionales de alta calidad y la capacitación sobre la manera de utilizarlas, y un sistema de seguimiento de datos.

La puesta en marcha del programa incluyó tres niveles de gestión. Cada nivel consta de un elemento de contenido y un elemento de sistemas: el objetivo era brindar a los directores contenidos de mejor calidad para que lo compartieran con los docentes y un sistema para que lo hicieran.

Nivel 1: Planificación de la enseñanza

Cada semana, los docentes debían presentar planes de clases y los directores debían evaluarlos y formular los comentarios pertinentes. Los directores habían recibido capacitación sobre “cómo brindar comentarios constructivos y pertinentes sobre la planificación de las clases de los docentes y cómo conducir una reunión de planificación con docentes”, así como sobre el proceso de “planificación regresiva”. Muchos docentes son partidarios de incluir actividades que generen el interés de los alumnos para enseñar determinados temas (por ejemplo, dice Fryer, construir un modelo de volcán cuando se enseña la unidad referida al tema) y decidir luego los aspectos que se evaluarán. En la “planificación regresiva” se determinan en principio los conocimientos que el docente desea evaluar y a partir de ello se trabaja para diseñar actividades que generarán dichos conocimientos.

Nivel 2: Instrucción basada en los datos

Los alumnos fueron evaluados cada seis a ocho semanas en lectura, matemáticas, ciencias y estudios sociales (en la práctica, las escuelas administraron más del 90 % de las evaluaciones). Luego de cada evaluación, los datos se cargaron a una plataforma de análisis de datos para que los docentes los analizaran y formularan planes de acción dentro del plazo de una semana a partir de la evaluación. Los directores (u otros dirigentes escolares) debían reunirse entonces con los docentes para transmitirles sus comentarios sobre los planes. La finalización de los planes de acción era menos homogénea: el 75 % de las escuelas del grupo de tratamiento presentaron al menos un plan de acción durante el año. Asimismo, se alentó a las escuelas a realizar evaluaciones formativas semanales (pruebas cortas), pero no se hizo un seguimiento de dichas evaluaciones. Las escuelas de control también tenían acceso a las evaluaciones, pero no a la capacitación sobre cómo incorporarlas en los planes de acción.

Nivel 3: Observación y comentarios

“Los directores debían garantizar que al menos una vez cada dos semana todos los docentes fueran observados durante 15 a 20 minutos mientras dictaban clases” ya sea por el director u otro directivo del establecimiento. El observador y el docente se reunían luego para analizar e “identificar al menos una medida clave que el docente debería implementar para mejorar la instrucción”. Los directores y los directivos habían recibido capacitación sobre cómo observar las clases, cómo conducir las reuniones seguimiento y cómo hacer el seguimiento de las observaciones. En las reuniones se aplicó un protocolo de seis pasos (documento Word en inglés) extraído del libro de Patrick Bambrick-Santoyo titulado Leverage Leadership (Liderazgo basado en la optimización de las capacidades). (i) Muchos utilizaban simplemente planillas de cálculo de Google para hacer el seguimiento de las observaciones.

Resultados

Los directores de las escuelas incluidas en el grupo de tratamiento participaron en el 58 % de las actividades de capacitación (frente al 1 % de los directores del grupo de control). Según la información administrativa, los docentes de las escuelas del grupo de tratamiento fueron observados —en promedio— 0,6 veces por mes, esto es, apenas más de una vez cada dos meses (frente a 0,04 veces por mes en las escuelas de control o una vez cada 25 meses). La diferencia es menor en los datos informados por los directores: 2,3 observaciones por docente por mes en el grupo de tratamiento frente a 1,3 en el grupo del control. Al final del primer año, el 80 % de los directores de las escuelas del grupo de tratamiento indicaron que su capacitación había sido más eficaz que el año anterior (esto es, que la capacitación tradicional), más del triple de lo registrado en las escuelas de control.

¿Qué sucede con el aprendizaje de los alumnos? Fryer examina los impactos sobre las pruebas importantes y las pruebas menores del primer año y luego sobre las pruebas importantes del segundo año. (El distrito eliminó progresivamente las pruebas menores estandarizadas para reducir el número total de días de evaluaciones). Como se puede observar en el siguiente cuadro, el programa tuvo un impacto significativo, sobre todo en su primer año, con la oferta de capacitación, que generó alrededor de 1 desviación estándar en el aprendizaje.

| Cuadro 4: El efecto del tratamiento en los puntajes obtenidos por los alumnos en las pruebas | ||||||

| Regresiones de referencia | Regresiones totalmente controladas | |||||

| 2015 | 2016 | Combinadas | 2015 | 2016 | Combinadas | |

| (1) | (2) | (3) | (4) | (5) | (6) | |

| Importantes (suma de puntajes en dos temas) | 0,101*** | 0,020 | 0,060*** | 0,076*** | 0,000 | 0,039*** |

| (0,014) | (0,015) | (0,010) | (0,013) | (0,014) | (0,010) | |

| N | 25,397 | 26,379 | 51,776 | 25,397 | 26,379 | 51776 |

| Menores (suma de puntajes en cuatro temas) | 0,188*** | -- | --- | 0,135*** | --- | --- |

| (0,028) | (0,027) | |||||

| 23,878 | 23,878 | |||||

Fuente: Fryer, 2017 . (PDF, en inglés) Las “regresiones de referencia” no incluyen a los grupos de control, a diferencia de las “regresiones totalmente controladas”. Los resultados están expresados en desviaciones estándar.

El programa funcionó mejor para algunos directores que para otros: funcionó mejor para los directores con título de grado, para los que habían obtenido mayores puntajes cuando eran estudiantes (en el SAT, [i] la prueba de admisión universitaria) y para los que habían obtenido puntajes más elevados en las pruebas socioemocionales ( perseverancia [i] y locus de control interno [i]).

En algunos casos, los efectos más significativos se observan en las escuelas que han tenido el mismo director durante los años del programa: se registró un aumento de 0,13 desviaciones estándar en las pruebas importantes y de 0,32 desviaciones estándar en las pruebas menores. Del mismo modo, se observa una marcada diferencia en la implementación: los directores que implementan el programa con más rigurosidad logran efectos mucho mayores. Desde luego, la implementación es endógena, pero, aunque se prevea la implementación utilizando características de los directores previas a la intervención, el cambio es claramente positivo. Fryer realiza además una serie de controles de solidez, incluidas múltiples correcciones de hipótesis, que dejaré para otra ocasión.

Eficacia en función de los costos

Fryer compara entonces el tamaño y los costos del efecto con otras varias intervenciones educativas realizadas en Estados Unidos y concluye lo siguiente:

- “El efecto de reducir el tamaño de las clases de 24 a 16 alumnos por docente constituye aproximadamente 0,24 desviaciones estándar por año en los puntajes acumulados de las pruebas de matemáticas y lectura, con un costo marginal de USD 5084 por alumno y una tasa interna de rentabilidad del 9,7 % (Krueger, 1999)”.

- “La escuela media del programa Zona de Niños de Harlem registra un aumento de 0,28 variaciones estándar por año en los puntajes acumulados de las pruebas de matemáticas y lectura, con un costo marginal de USD 7536 y una tasa interna de rentabilidad del 11,9 % (Dobbie y Fryer, 2011)”.

- “En el marco del programa de Teach for America se incrementaron en 0,18 desviaciones estándar por año los puntajes acumulados de las pruebas de matemáticas y lectura, con un costo marginal de USD 3707 y una tasa interna de rentabilidad del 11,7 % (Glazerman y otros, 2006)”.

- “El costo marginal promedio por alumno de nuestro experimento es de USD 9,26 por alumno al año... Esto implica una tasa interna de rentabilidad del 79 %, la más alta de todas aquellas calculadas a partir de datos experimentales”. Asimismo, si los distritos escolares pueden dirigir la capacitación en gestión a los directores que, a priori, probablemente permanecerán en sus puestos de trabajo mientras dure la capacitación o implementarán la capacitación con gran rigurosidad, la tasa interna de rentabilidad es del 94 % o el 96 %, respectivamente”.

Nada mal.

Los directores de escuela pueden mejorar. Pero este ejemplo es una intervención intensiva de múltiples dimensiones y la calidad de la implementación fue determinante. Por lo tanto, mejoremos la calidad de los directores, pero no esperemos que sea una tarea fácil.

Lectura adicional:

- El estudio de Branch y otros (2013) publicado en Education Next (citado más arriba) (i) se basa en un documento de trabajo más extenso de la Oficina Nacional de Investigación Económica (i) de 2012.

- Apéndice (PDF, en inglés) de Fryer en el que se describe detalladamente el programa.

Únase a la conversación