Escola do Amanha at Complexo do Alemao

Escola do Amanha at Complexo do Alemao

O Objetivo de Desenvolvimento Sustentável 4 (ODS 4), estabelecido no contexto da Agenda 2030, define como meta assegurar uma educação de qualidade inclusiva e equitativa e promover oportunidades de aprendizagem ao longo da vida para todos. Para monitorar o progresso e cumprimento deste compromisso, é essencial fazer uso de medidas precisas dos resultados de aprendizagem. Graças à Aliança Global para Monitorar Aprendizado (GAML, em inglês), foi construído um consenso sobre os padrões mínimos internacionais para medir o aprendizado em diferentes séries e disciplinas, com valores correspondentes nas escalas de avaliações de aprendizagem nacionais e internacionais.

Alguns países como a China, Etiópia, Índia, Paquistão e Uganda usam atualmente suas avaliações nacionais para reportar seus indicadores dos ODS 4. Outros países, como o Brasil, reportam seus indicadores ODS usando exclusivamente avaliações internacionais ou regionais; mais precisamente, as avaliações LLECE, para anos iniciais do ensino fundamental, e PISA, para os anos finais do sistema educacional. Além disso, o Brasil realiza a cada dois anos uma avaliação nacional censitária - a Prova Brasil - e usa a pontuação média para calcular e monitorar sistematicamente seu Índice de Qualidade da Educação Básica (IDEB).

A coexistência de avaliações nacionais e internacionais e de diferentes métricas para acompanhar o desempenho de um mesmo sistema educacional suscita as três questões abordadas neste blog: (1) Como os resultados de aprendizagem se comparam entre avaliações? (2) Como as avaliações nacionais e internacionais podem ser alinhadas? (3) Qual a importância da escolha do indicador de resultados de aprendizagem?

1. Comparando avaliações de aprendizagem: contrastando fotografias nacionais e internacionais

Comparar duas avaliações de aprendizagem é um desafio, mesmo que elas pretendam medir o mesmo conteúdo e a mesma população estudantil. Na psicometria, este desafio é conhecido como linking. É como comparar duas fotos da mesma floresta, tiradas com dias de intervalo, usando diferentes lentes, velocidade, luz e sensibilidade de filme. O tempo da foto reflete os alunos sendo avaliados em diferentes séries ou momentos do ano letivo. A amostragem em cada avaliação, semelhante à sensibilidade do filme, pode dar uma imagem mais ou menos precisa da aprendizagem e limitar nossa capacidade de ampliar a imagem. Finalmente, cada avaliação tem sua própria escala para medir a proficiência; assim como uma lente grande angular captura um amplo escopo, uma lente teleobjetiva permite ao fotógrafo registrar uma área reduzida em detalhes. Todos estes fatores combinados podem criar composições contrastantes ao destacar aspectos distintos de um mesmo assunto.

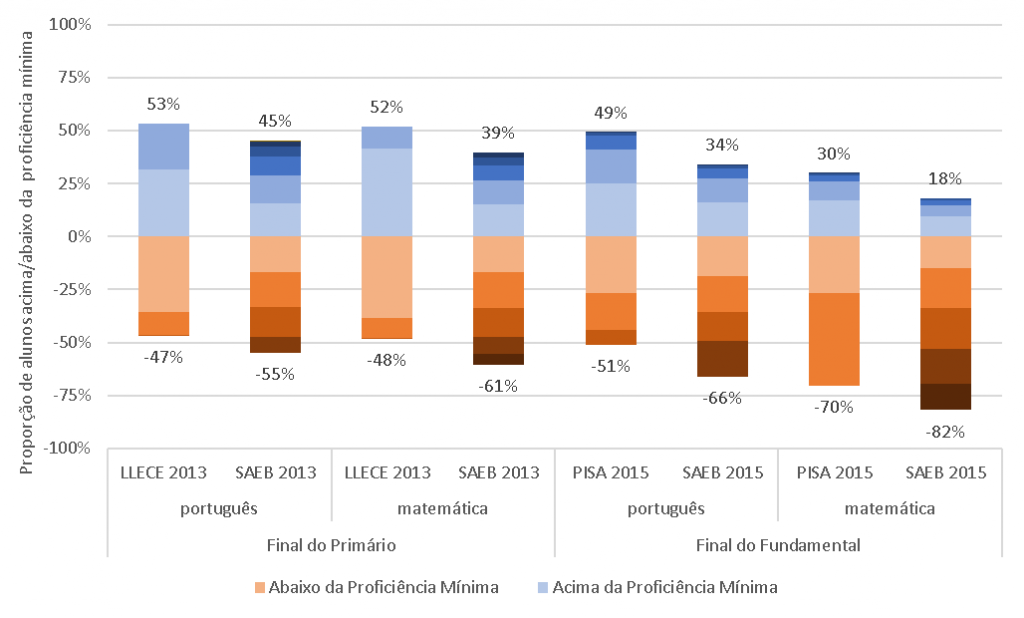

Vamos usar esta analogia fotográfica para comparar os resultados do aprendizado em português e matemática no Brasil utilizando como base avaliações nacionais e internacionais. Para tanto, é preciso definir as premissas utilizadas na análise fotográfica. Primeiramente, para minimizar a diferença no momento das fotos, selecionamos a combinação mais próxima de anos e séries: no final do ensino primário, comparamos o resultado da Prova Brasil – reportado na escala SAEB – dos alunos do quinto ano com o resultado da LLECE dos alunos do sexto ano, ambos em 2013. No final do ensino fundamental, analisamos os resultados do PISA aplicado a estudantes de 15 anos e os contrastamos com a avaliação Prova Brasil aplicada aos alunos do nono ano, ambos em 2015. Vale notar que as resoluções (ou sensibilidade da película fotográfica) adotadas diferem significativamente: LLECE e PISA são baseados em amostras e avaliam alguns milhares de alunos cada, enquanto a Prova Brasil testa cerca de 2 milhões de alunos em cada série. Finalmente, para avaliar o alcance dos limites mínimos de proficiência nas diferentes avaliações, utilizamos o parâmetro definido pelo GAML no caso do LLECE e PISA ao passo que para a Prova Brasil usamos as pontuações mínimas (na escala SAEB) propostas por especialistas convocados pela ONG Todos pela Educação em 2006.

Como se comparam essas fotos da aprendizagem no Brasil? A figura 1 ilustra nossas conclusões. Cada barra representa a proporção de alunos por nível. As barras de cor laranja representam a proporção dos alunos abaixo da proficiência mínima, enquanto as barras em azul representam a proporção daqueles acima do nível mínimo de proficiência ; cada tonalidade corresponde a um nível de proficiência definido por pontos de corte nas respectivas escalas. Observamos que a proporção de alunos abaixo do nível mínimo de proficiência na avaliação nacional é consistentemente maior do que a proporção encontrada em avaliações internacionais. A princípio, tal discrepância poderia ser explicada por três fatores: (i) os alunos são testados em séries anteriores no exame nacional; (ii) o nível de aspiração nacional pode ser mais ambicioso que o internacional; ou, (iii) as escalas não são estritamente comparáveis.

Figura 1 - Proporção de alunos em cada nível de proficiência, por disciplina nas avaliações nacionais e internacionais

Nota: para obter detalhes sobre os níveis de proficiência de cada avaliação disponível, consulte LLECE, SAEB, PISA

2. Alinhando escalas de avaliações nacionais e internacionais

Uma questão central inerente ao exercício de comparação entre diferentes avaliações de aprendizagem, sejam elas nacionais ou internacionais, se refere à comparabilidade das escalas usadas para gerar indicadores. Neste contexto, uma das maiores contribuições da GAML foi mudar o foco da discussão sobre métricas dos indicadores, abandonando a ambição de uma escala comum - o que exigiria que todos os países aplicassem a mesma avaliação de forma a gerar resultados comparáveis - e introduzindo uma Matriz Global de Proficiência. Essa Matriz descreve as competências que os estudantes devem dominar para serem considerados proficientes em cada etapa. O seu uso possibilita comparar avaliações em diferentes países, sem exigir o uso de uma escala única. Embora menos precisa, esta abordagem possui a vantagem de utilizar sistemas de avaliação de aprendizagem já existentes e pode aumentar a compreensão e a apropriação dos resultados da avaliação pelos países, facilitando o alcance do ODS4. Com base nessa Matriz, os especialistas do GAML mapearam os níveis de proficiência de várias avaliações de aprendizagem internacionais ( por exemplo, PISA e PIRLS) e regionais (por exemplo, LLECE, SAQMEC, e PASEC) em um continuum e identificaram os níveis mínimos de proficiência a serem atingidos em três momentos do ciclo educacional: inicio do primário (entre 1.o e 3.o ano), final do primário (de 4.o a 6.o ano), e início do secundário (de 7.p a 9.o ano).

Para implementar esse mapeamento entre os níveis de proficiência de avaliações nacionais e os níveis de proficiência mínimos usados pelo ODS4 e definidos pela referida Matriz, é fundamental ir além de uma triangulação empírica, como feita neste blog (Figura 1). A última conferência do GAML, realizada em outubro de 2020, discutiu algumas técnicas para realizar esse exercício de mapeamento. São elas:

1. Incluir itens globais nas avaliações nacionais de aprendizagem que poderão ser usados para ‘linkar’ psicometricamente as duas escalas de proficiência a serem comparadas (ao nível nacional e a definida no âmbito da Matriz Global de Proficiência);

2. Adotar a abordagem da Pedra Rosetta da UIS/IEA, segundo a qual duas avaliações de aprendizagem com diferentes escalas – uma nacional e outra internacional - são aplicadas a um mesmo grupo de estudantes gerando um fator de conversão que pode ser utilizado para traduzir resultados dos indicadores. Esta abordagem vem sendo testada pelo Laboratorio da UNESCO/UIS/IEA na Colômbia e Guatemala para ‘linkar’ a escala do LLECE com a escala do PIRLS; ou

3. Realizar “linkagem” por moderação social, onde especialistas da avaliação nacional juntamente com especialistas internacionais mapeiam as pontuações mínimas que demonstram o domínio da competência avaliada nas diferentes escalas (atualização da “linkagem” apresentada na 7ª reunião do GAML).

3. Escolhendo o indicador de resultados de aprendizagem

O Brasil possui um sólido sistema de monitoramento educacional: a Prova Brasil permite avaliar a aprendizagem dos alunos, enquanto o Censo Escolar por aluno permite acompanhar as trajetórias de escolarização individualizadas.

Além desses instrumentos de coleta de dados, o país adotou o IDEB como uma forma simples de comunicar o seu monitoramento educacional, tanto em termos de escolarização quanto de aprendizado. Ele é um indicador multidimensional, composto pelo produto de dois termos: (i) a média das notas dos testes de português e matemática no final de cada ciclo educacional; e (ii) a média harmônica da taxa de aprovação de todos os anos do respectivo ciclo educacional. O IDEB é amplamente divulgado pela mídia nacional e constitui a principal métrica de referência do desempenho de sistemas de educação municipais e estaduais no Brasil.

Apesar do uso disseminado e metodologia robusta, o IDEB possui alguns ‘pontos cegos’. O primeiro deles se refere ao uso da pontuação média do teste, o que pode mascarar importantes aspectos referentes a distribuição da medida de aprendizagem na população de alunos. Como ilustra a Figura 2, a nota média e a proporção de alunos abaixo do nível mínimo de proficiência não se movem na mesma velocidade. Enquanto a proporção de alunos que não conseguem ler proficientemente no final do primário caiu quase pela metade (de 72% para 39%) entre 2007 e 2019, a média das notas aumentou apenas 22% no mesmo período. [Você pode interagir com a figura para visualizar outros anos, disciplinas e etapas]. Isso acontece porque as mudanças na proporção de alunos proficientes é impactada por mudanças tanto na pontuação média quanto na distribuição da pontuação na população de alunos (veja outro blog que discute este ponto usando dados do PISA). Neste sentido, é importante destacar que sistemas educacionais que queiram ter uma métrica sensível às desigualdades de aprendizagem não devem se basear em notas médias. O foco nos estudantes com pior desempenho é o primeiro passo para um maior compromisso com a equidade educacional.

Figura 2 - Evolução da pontuação média e proporção de alunos abaixo da proficiência mínima

O segundo ‘ponto cego’ refere-se a possibilidade de inflar os resultados de avaliações de aprendizagem do IDEB através da redução da taxa de participação dos estudantes (i.e. a proporção entre os alunos que fazem a prova e o número total de alunos matriculados) com menor desempenho esperado. Apesar de mitigar este problema nos seus resultados por escola, uma vez que o IDEB só é reportado para escolas com uma taxa de participação acima de 80%, o mesmo não ocorre com o IDEB por município e estado, onde as notas dos alunos de escolas com baixa participação são incluídas na média final.

Olhando para frente, é possível identificar algumas oportunidades para melhorar o IDEB. A primeira delas seria incluir a taxa de participação dos alunos na Prova Brasil como um componente na fórmula de cálculo do IDEB. Este componente poderia operar como um fator de ajuste da nota final, valorizando os esforços de estados e municípios que buscam ampliar a taxa de participação dos seus alunos no exame nacional. A segunda possibilidade de melhoria seria utilizar a proporção de alunos abaixo de um patamar mínimo de proficiência como medida de aprendizado. Como visto acima, este indicador alternativo é sensível a mudanças na distribuição da notas dos alunos. A terceira melhoria potencial seria ajustar o indicador pela proporção dos alunos fora da escola ou com grandes defasagens idade-série de forma a aumentar a sensibilidade do IDEB à equidade de acesso à educação

A mensuração da aprendizagem é parte fundamental de uma política educacional baseada em evidências. Neste contexto, as escolhas de medidas importam. E muito.

Queremos ouvir suas opiniões!

Juntar-se à conversa